Este artículo es un segundo extracto de la charla que di en #ProductFest241, en la que hablo de diseño e IA responsable en asistentes de voz. En la charla, más completa, exploro algunas de las tecnologías de los asistentes como ChatGPT (modelos de lenguaje o LLMs y voces sintéticas) partiendo del impacto que tuvo la demo de GPT-4o2 de OpenAI lanzado en mayo de 2024.

Lee el primer extracto de la charla: “¿De qué está hecho ChatGPT?”.

¿Qué buscamos en las interfaces conversacionales?#

Cuando hablamos con Alexa o Siri, buscamos que nos sean de utilidad, por supuesto. Pero es que cuando hablamos con un asistente de voz o chatbot, tenemos expectativas muy específicas que van más allá de la simple funcionalidad. Esperamos a grandes rasgos:

- Comunicación natural: Queremos que la conversación fluya de manera espontánea, en nuestro idioma, que mantenga el contexto de lo que hemos hablado anteriormente y que tenga memoria de nuestras interacciones. No buscamos comandos robóticos, sino diálogos naturales.

- Conexión emocional: Buscamos más que una herramienta; queremos un ente digital que tenga personalidad, que pueda ofrecernos apoyo cuando lo necesitemos, que comprenda nuestras emociones y responda con empatía. En algunos casos, especialmente cuando buscamos combatir la soledad, esta conexión se vuelve aún más importante.

- Inteligencia real: Esperamos que estos sistemas no solo procesen información, sino que realmente entiendan el entorno, que perciban lo que les decimos, que sean capaces de razonar y que respondan de manera inteligente. Queremos que vean, escuchen y comprendan como lo haríamos nosotros.

- Confianza absoluta: Necesitamos que sean veraces y fiables. Al final, estos asistentes están ahí para ayudarnos a conseguir objetivos importantes, por lo que es indispensable que tengan conocimiento sólido, que nos proporcionen información exacta y que nos recomienden siempre lo mejor para nosotros.

Son estas características las que hacen que se democratice el uso de estas interfaces, ya que si no son útiles para nuestro día a día, para qué queremos conversar con ellas. Usamos otro método de interacción o resolvemos el problema de otra manera. Y si no, que se lo digan a los múltiples altavoces inteligentes (smart speakers) de Google o Alexa que “duermen” desenchufados en cajones.

El problema de la cooperación conversacional#

Y es que esto va de conversar. Cuando hablamos entre personas, seguimos el principio de cooperación de Grice3. Esperamos que nuestro interlocutor sea cooperador, y que no sea un delincuente conversacional4, para que la conversación sea lo más efectiva posible. Este principio se define por las siguientes cuatro máximas:

- Máxima de calidad: No mentimos (no somos Pinocho).

- Máxima de cantidad: Damos la información justa y necesaria.

- Máxima de relevancia: No nos vamos por los cerros de Úbeda.

- Máxima de manera: Adaptamos nuestro estilo al interlocutor y contexto.

En las interfaces conversacionales tradicionales, diseñábamos las respuestas del asistente teniendo este principio en cuenta. Es decir, el diseño de conversaciones y las personas profesionales de esta disciplina teníamos en cuenta estas máximas a la hora de crear experiencias.

Profundiza leyendo “Cómo funcionan los chatbots”.

¿Pero qué sucede con las interfaces conversacionales basadas en modelos de lenguaje (LLMs)? Como ya estarás pensando, el problema es que los modelos de lenguaje no son naturalmente cooperativos. Sabemos que alucinan información errónea, dan información excesiva o irrelevante, y no siempre adaptan su estilo al contexto adecuado.

Esta es la razón por la que los modelos de lenguaje de manera aislada no son los mejores para mantener conversaciones. Si no podemos confiar, ¿de qué nos sirve? Es por esto que con tecnologías como RAG (Retrieval-Augmented Generation) intentamos hacer que estos sistemas sean más fiables, aunque aún sin garantías absolutas.

No te pierdas mis últimos artículos. Suscríbete a mi newsletter “Fallback Intent”.

Utilizar la IA con cuidado (handle with care)#

Como creadores de productos conversacionales, debemos utilizar estas tecnologías de Inteligencia Artificial con cuidado, considerando varios aspectos críticos:

-

Datos y consentimiento: La voz es identidad, es un dato personal. El caso de Scarlett Johansson con OpenAI para el lanzamiento de GPT-4o en mayo de 20245 ilustra perfectamente este dilema: aunque desde OpenAI dijeran que no era su voz, el parecido era innegable, y además había antecedentes relacionados con la película “Her”6. Siempre debemos trabajar con autorización y respeto hacia las personas y su imagen.

-

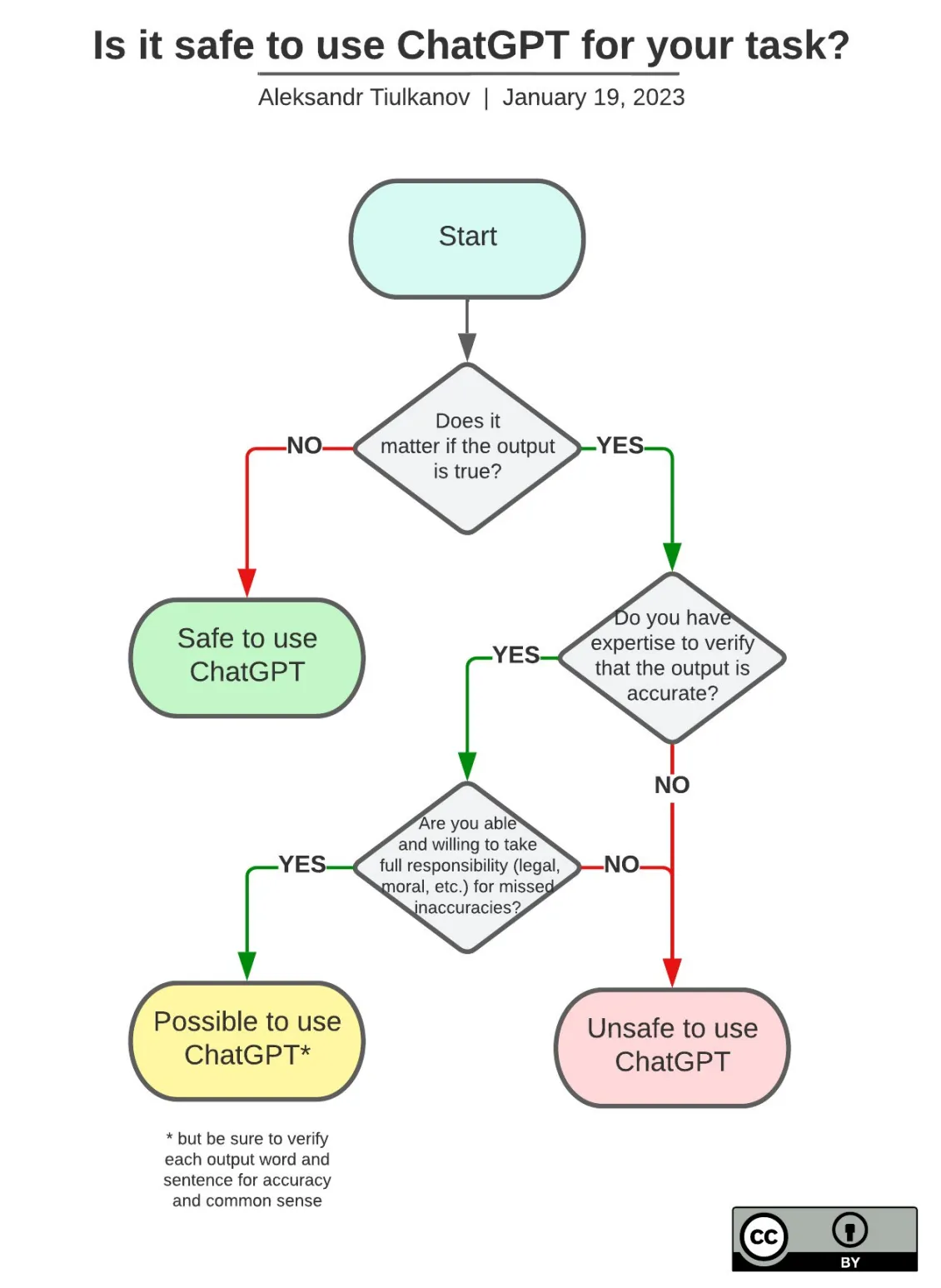

Seguridad y veracidad: Existe un diagrama de flujo simple pero efectivo para decidir si es seguro usar modelos de lenguaje7: ¿Importa que la respuesta sea verdad? Si la respuesta es sí, debemos preguntarnos si tenemos la experiencia suficiente para validar la respuesta y si estamos dispuestos a aceptar la responsabilidad de cualquier inexactitud.

¿Es seguro usar ChatGPT para esa tarea?. Fuente: Aleksandr Tiulkanov7.

¿Es seguro usar ChatGPT para esa tarea?. Fuente: Aleksandr Tiulkanov7.

Un ordenador nunca debería ser responsable. Por lo tanto, un ordenador no debería tomar decisiones de negocio. - IBM (1979) 8.

-

Antropomorfización: Tendemos naturalmente a atribuir características humanas a estos sistemas, pensando que razonan o tienen capacidades que realmente no poseen. Esto es muy común en los medios de comunicación, con titulares como “En 1927, un arqueólogo descubrió estos geoglifos. Ahora, la IA ha encontrado otros 300”9 o “OpenAI lanza o1, el nuevo ChatGPT de las matemáticas capaz de razonar como un humano”10. Es fundamental ser transparentes sobre las capacidades y limitaciones, y si creamos producto con IA, siempre avisar a los usuarios que están interactuando con sistemas técnicos, no con personas.

-

Sesgos de género: ¿Por qué todos los asistentes de voz tienen voces femeninas?11 Alexa, Siri, Cortana de entre los asistentes más comerciales, pero solo tienes que echar un vistazo a cualquier chatbot o asistente de los últimos años. No solo la voz, también nombre de mujer. Un ejemplo es LuzIA, que además sigue con la moda de resaltar la “IA” en el nombre. Pero es que los modelos de lenguaje también tienen sesgos. Por ejemplo, en un estudio de la UNESCO12 en tareas de asociación de palabras con género, Ada-002 (un modelo de lenguaje de OpenAI) mostró una fuerte tendencia a asociar nombres femeninos con “hogar”, “familia”, “hijos” y “matrimonio”, mientras que los nombres masculinos se asociaban con “negocios”, “ejecutivo”, “salario” y “carrera”. Estos sesgos de género estaban presentes en otros modelos de lenguaje como GPT-2 y Llama 2 (open source), en la forma en que asocian el género con las carreras y roles, y en el tipo de contenido que generan sobre hombres y mujeres en contextos profesionales y sociales. Los sesgos no solo vienen de decisiones de negocio, sino también de los datos de entrenamiento.

Democratización vs. responsabilidad#

La IA conversacional no es magia, son herramientas que podemos usar para romper barreras y crear experiencias más humanas e inclusivas. La clave está en entender qué hay detrás de la tecnología y usarla de manera responsable.

Estas tecnologías están reduciendo dramáticamente la brecha entre “tengo una idea” y “puedo hacerla realidad”, incluso sin conocimientos técnicos profundos. Están democratizando la creación de herramientas conversacionales de una manera que no imaginamos.Pero con esta democratización viene la responsabilidad. Antes había muchas cosas que no podíamos hacer; ahora que sí podemos hacerlas, está en nuestras manos decidir cómo queremos hacerlas.

La pregunta ya no es si podemos crear asistentes que conversen como personas, sino cómo queremos que lo hagan. ¿Priorizaremos la diversidad lingüística y cultural? ¿Seremos transparentes sobre las capacidades y limitaciones? ¿Usaremos estas tecnologías para hacer el mundo más accesible e inclusivo para más gente? Esas decisiones está en nuestras manos como creadores de productos y experiencias.

Footnotes#

-

Nieves Ábalos, 27/09/2024. Charla en #ProductFest24: “La realidad de la IA Conversacional: De qué está hecho Chat GPT” ↗. ↩

-

OpenAI, 2024. GPT-4o - “Live demo of GPT-4o realtime conversational speech” ↗. ↩

-

Paul Grice, 1975. Logic and conversation - Principio de cooperación ↗. ↩

-

Estrella Montolio, 2021. Cómo nos define nuestro lenguaje. Youtube #AprendemosJuntos BBVA ↗. ↩

-

The New York Times, 2024. “Scarlett Johansson Said No, but OpenAI’s Virtual Assistant Sounds Just Like Her” ↗. ↩

-

Wired, 2024. “I Am Once Again Asking Our Tech Overlords to Watch the Whole Movie” ↗. ↩

-

Aleksandr Tiulkanov, 2023. “Is it safe to use ChatGPT for your task?” ↗. Source LinkedIn article ↗. ↩ ↩2

-

IBM, 1979. “A computer can never be held accountable” - Tweet de MIT CSAIL ↗. ↩

-

El confidencial, 2024. “En 1927, un arqueólogo descubrió estos geoglifos. Ahora, la IA ha encontrado otros 300” ↗. ↩

-

ABC, 2024. “OpenAI lanza o1, el nuevo ChatGPT de las matemáticas capaz de razonar como un humano” ↗. ↩

-

The Guardian, 2019. “Adios, Alexa: why must our robot assistants be female?” ↗. ↩

-

UNESCO, 2024. “Challenging systematic prejudices: an investigation into bias against women and girls in large language models” ↗. ↩